Wymóg posiadania idealnego chipa nie stanowi już problemu dla wszystkich zainteresowanych tą branżą.

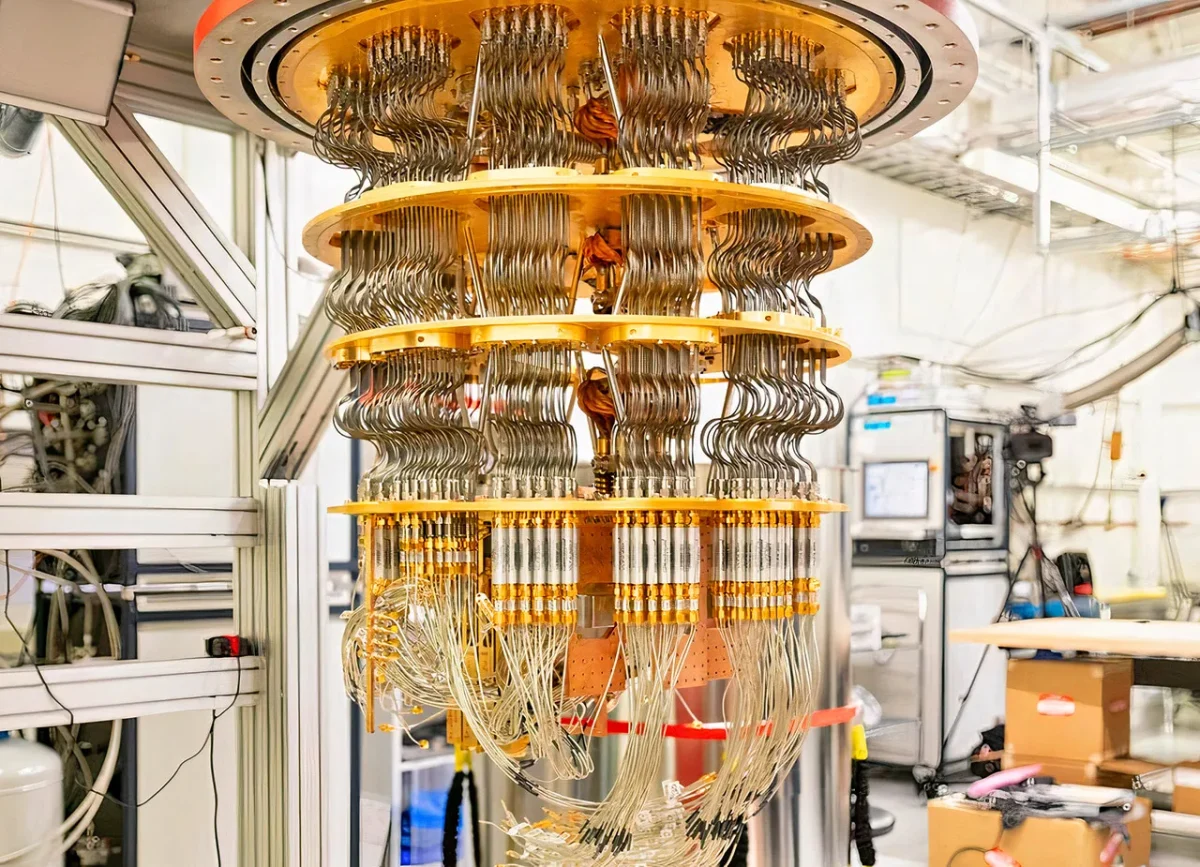

Informatyka kwantowa jest jedną z dziedzin, która budzi największe emocje wśród miłośników sektora technologicznego. Przykładem może być Jensen Huang, obecny dyrektor generalny Nvidia i jedna z osób, które najbardziej wierzą w osiągnięcie postępów w tej dziedzinie. W rzeczywistości Huang nie jest jedyny, ponieważ inne firmy, takie jak IBM czy Google, również podjęły pierwsze kroki, aby przyczynić się do rozwoju informatyki kwantowej. Teraz, ku ich zaskoczeniu, grupa naukowców z Uniwersytetu Kalifornijskiego udowodniła, że nie potrzebują idealnych chipów kwantowych, aby budować skalowalne systemy.

Jak wskazuje TechSpot, obecnie możliwe jest montowanie niezawodnych komputerów kwantowych z mniejszych, połączonych ze sobą chipów, które nie muszą być idealne. Postęp ten może przyspieszyć pojawienie się komputerów kwantowych zdolnych do rozwiązywania złożonych problemów na dużą skalę, co giganci branży technologicznej badają od lat. Na szczęście dla nich badania naukowców z Riverside wykazały, że tolerancja na błędy jest jednym z kluczy do przyszłości informatyki kwantowej.

Odkrycie, które zmniejsza wymagania branży

Według naukowców tolerancja na błędy ma kluczowe znaczenie, ponieważ umożliwia automatyczne wykrywanie i korygowanie błędów. Tradycyjnie postęp mierzył się liczbą kubitów, ale brak tolerancji na błędy sprawiał, że wyniki nie były same w sobie użyteczne. Dzięki pracy kierowanej przez Mohameda A. Shelby’ego, doktoranta fizyki i astronomii na Uniwersytecie Kalifornijskim w Riverside, informatyka kwantowa może dokonać tego przełomu, którego niektórzy od dawna poszukiwali.

Aby osiągnąć uzyskane wyniki, badanie wskazuje, że przeprowadzono tysiące symulacji w celu przetestowania sześciu różnych projektów modułowych, wszystkie inspirowane infrastrukturą kwantową Google. W ten sposób jedną z głównych przeszkód jest szum w połączeniach między chipami, zwłaszcza jeśli znajdują się one w oddzielnych chłodziarkach kriogenicznych. Co zaskakujące, pomogło to zespołowi odkryć, że nawet przy połączeniach dziesięciokrotnie bardziej zakłóconych niż same chipy, system był w stanie korygować błędy, jeśli chipy zachowywały wysoką wierność.

Dzięki temu odkryciu naukowcy twierdzą, że obliczenia kwantowe mogą zmniejszyć wymagania sprzętowe do budowy wielkoskalowych systemów kwantowych. Badania, jak wynika z oryginalnej publikacji, opierały się na kodzie powierzchniowym, obecnie najczęściej stosowanej technice korekcji błędów. W wyniku tych badań wykazano, że przy użyciu architektury modułowej możliwe jest kodowanie solidnych i wysokiej jakości kubitów logicznych, co udaje się osiągnąć pomimo niedoskonałych połączeń.